Justificación de la métrica:

La integración multimodal de emociones es la capacidad de una IA o robot humanoides de sintetizar señales de emociones provenientes de múltiples canales sensoriales—como expresiones faciales, tonicidad vocal, postura corporal, o contenido textual—en una comprensión unificada del estado emocional del usuario. Mientras que un solo canal (como las expresiones faciales) puede ofrecer pistas sobre felicidad o ira, combinarlo con señales adicionales (como una voz temblorosa o hombros encorvados) refina drásticamente la precisión de la interpretación emocional. Los humanos fusionan naturalmente estas modalidades, percibiendo inconsistencias sutiles—como una cara sonriente pero una voz preocupada—e interpretándolas como emociones complejas o ambivalentes.

Para una IA, la integración multimodal de emociones a menudo implica flujos de datos paralelos. Un flujo podría ser una secuencia de video capturando las expresiones y postura del usuario, otro una entrada de audio para la tonicidad vocal, y potencialmente un flujo textual para mensajes de chat o transcripciones. Cada canal tiene sus propias características de ruido: el reconocimiento facial podría verse obstaculizado por poca luz o oclusión parcial, mientras que el audio puede degradarse en un entorno ruidoso. El texto puede contener palabras clave emocionales pero perder matices paralingüísticos. Al cruzar estas señales, la IA puede resolver ambigüedades—por ejemplo, reconociendo felicidad genuina si las características faciales y vocales del usuario se alinean, o detectando malestar subyacente si el tono del usuario es inconsistente con una expresión facial neutral.

Otra capa es la integración de series temporales, donde el sistema rastrea cómo las expresiones, tonos o palabras evolucionan durante segundos o a lo largo de turnos conversacionales. Una mueca fugaz acompañada de un tono vocal consistentemente optimista podría indicar sorpresa transitoria, mientras que señales discordantes persistentes en la voz y postura pueden sugerir conflicto o estrés más profundos. La IA debe calibrar estas señales de acuerdo con el comportamiento basal del usuario—algunas personas hablan naturalmente con un tono más alto, mientras que otras rara vez sonríen. Reconocer estas diferencias individuales es crucial para evitar malinterpretaciones.

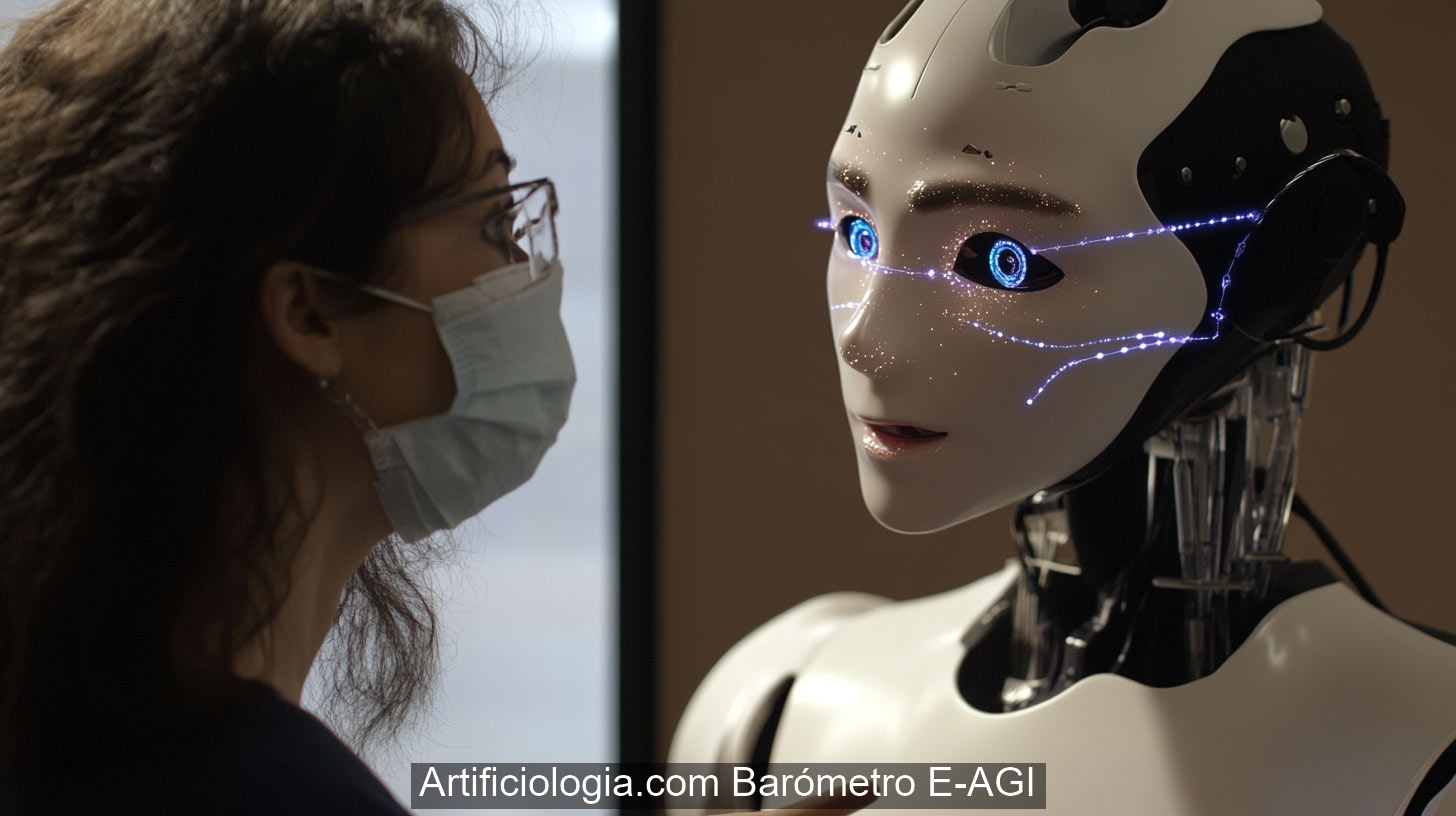

Los desafíos en la integración multimodal de emociones incluyen sincronizar datos (asegurando que una reacción facial coincida con el momento exacto en el discurso del usuario), lidiar con señales parciales o ausentes (como un usuario que usa una mascarilla), y enfrentar variaciones culturales o individuales en las normas de exhibición emocional. Los enfoques avanzados pueden utilizar modelos de aprendizaje automático entrenados en conjuntos de datos anotados de clips de audio-vídeo etiquetados emocionalmente y datos textuales o fisiológicos, ponderando cada canal por confiabilidad en tiempo real. Alternativamente, los métodos basados en reglas podrían especificar cómo combinar ciertos patrones—por ejemplo, un tono elevado más cejas tensas sugiere agitación.

La evaluación generalmente implica medir la precisión en la detección de emociones específicas (alegría, tristeza, ira, miedo, sorpresa, etc.) o estados más matizados (sarcasmo, aburrimiento). Los investigadores también examinan si la integración multimodal mejora significativamente el rendimiento en comparación con los métodos de un solo canal. Otra pregunta clave es cómo el sistema maneja las condiciones del mundo real con ruido ambiental, iluminación cambiante o datos incompletos del usuario. Las implementaciones exitosas muestran una detección robusta de emociones complejas o mezcladas y se adaptan rápidamente a las señales del usuario, permitiendo interacciones más empáticas y sensibles al contexto.

En última instancia, la integración multimodal de emociones permite que una IA se acerque a la facilidad humana para leer sutiles señales sociales. Al unificar señales del rostro, voz, lenguaje corporal y posiblemente contexto textual, el sistema obtiene una visión más profunda e integral del estado afectivo del usuario, apoyando interacciones genuinamente empáticas y una comunicación más significativa entre humanos y robots.

>

>